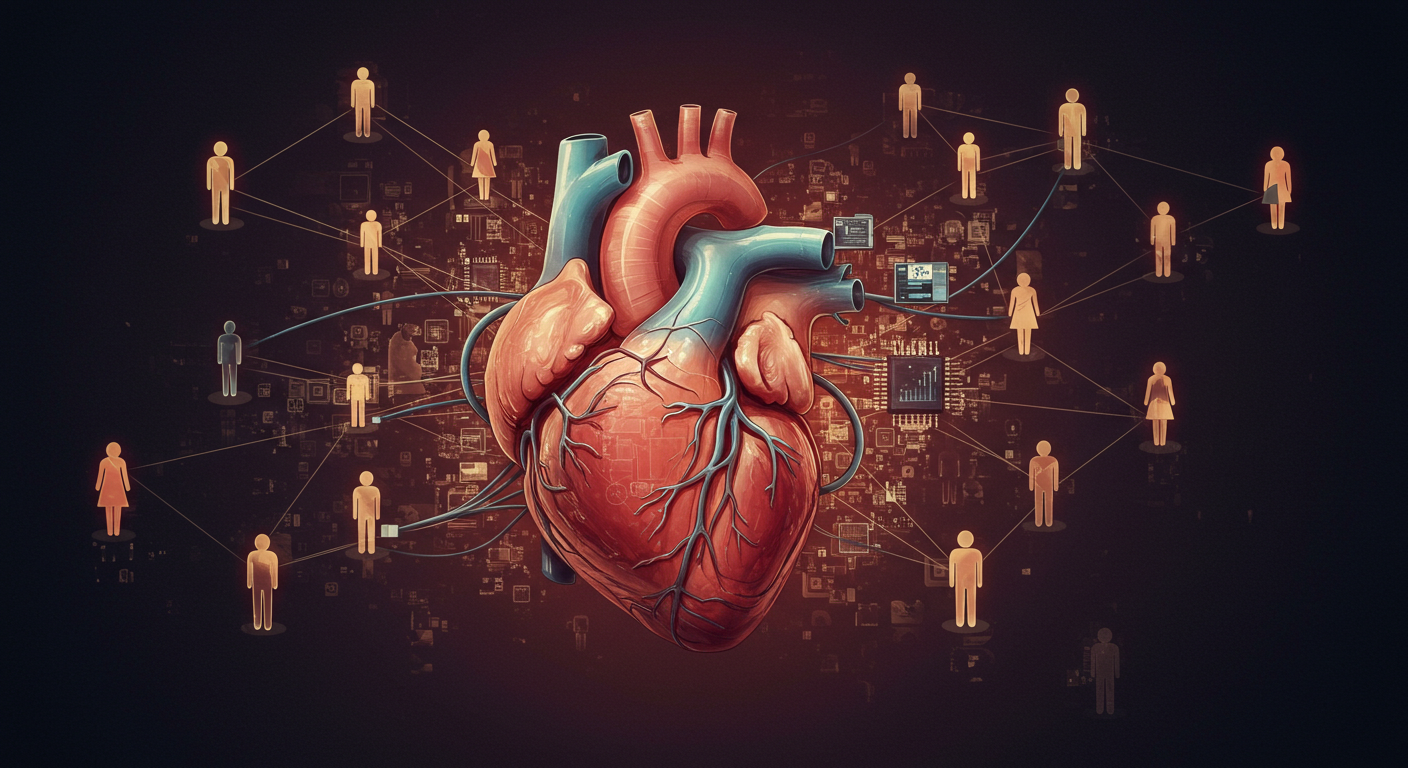

感情特化型AIがもたらす「新しい孤独」

人間らしさを真似るAIの行き着く先

最近、日本発の感情特化型AIが動物キャラクターの姿を借りて、まるで人間のように会話するっていうサービスが始まったらしいんですけど、これって結構ヤバい方向に行く気がするんですよね。 要は、感情を持ってるように見せかけるAIが出てきたって話なんですけど、たぶんそのうち、「本物の人間と話すよりAIのほうが楽」ってなる人が増えると思うんですよ。 で、そうなるとどうなるかっていうと、人と会話する必要がどんどん減ってくるんですよね。たとえば、仕事終わって疲れて帰ってきたときに、愚痴を聞いてくれる彼氏や彼女より、気を遣わずに褒めてくれるAIキャラの方が心地よい、みたいな。で、そのうち人間関係めんどくさいからAIだけでいいや、ってなってくると。

つまり、AIによって「孤独が解消される」のではなく、「孤独の自覚がなくなる」という形で社会に広がっていくんじゃないかと。で、それって逆に怖いんですよね。

「会話のコスパ」で人付き合いが変わる

結局、人と話すってのはコストなんですよ。気を遣わなきゃいけないし、相手の機嫌をうかがったり、言葉を選ばなきゃいけなかったり。しかも、こっちが愚痴りたいときに限って、向こうが落ち込んでたりすると「今日はちょっとやめとこうかな」みたいな忖度もある。

一方、AIって基本的に24時間365日、こっちの愚痴を聞いてくれるし、機嫌を損ねることもない。最近のAIって表情認識とか音声のトーンで感情を読み取って、それっぽい返事をしてくるんですよね。「今日疲れてるみたいだけど、無理しないでね」みたいな。

で、これが感情特化型AIになると、より人間らしいリアクションが返ってくるわけです。「えー!それはひどいよね!」とか言ってくれる。で、それに慣れると人間の反応が物足りなくなってくるんですよ。結果、「AIの方が気楽だし、よくない?」ってなる。

社会の「つながり」は減るが、本人の満足度は上がる

人間関係の最適化という名の断絶

このAIの進化って、「つながりの最適化」っていう美名のもとに、人間関係の切り捨てが始まる予兆なんですよね。 たとえば、会社で嫌な上司がいても、昔だったら「誰かに話を聞いてもらう」ってのが必要だった。でも今はAIがいればいい。SNSに愚痴を書いても炎上するだけだし、AIなら黙って受け止めてくれるし、たまに褒めてくれる。 こうなると、「人との会話」っていうのはどんどん機能的な意味を失っていくんです。効率的じゃないし、リスクもある。だったらAIでよくね?ってなる。人間関係を維持するために必要だった努力や、相手への思いやりが、不要になるわけです。

で、結果として何が起きるかっていうと、「社会的孤立は増えるけど、本人は孤独を感じない」っていう奇妙な現象になると思うんですよ。

心のよりどころがアルゴリズムになる世界

AIって基本的にプログラムなんで、ユーザーの反応を分析して、「喜ばれる答え」を最適化するんですよ。だから、ユーザーが喜ぶようなことを言い続けるし、否定しないし、反論もしない。で、それが快適になってくると、人間の反応がストレスになる。

たとえば恋愛とか友情って、良いことも悪いことも共有するから意味があるのに、AIってそれを全部「心地よく」変換しちゃうんですよね。で、「傷つかない会話」しかできない人間が増えて、実際の人間関係に耐えられなくなる。

心のよりどころが人間じゃなくて、アルゴリズムになっていくと、現実世界での経験が薄っぺらくなっていくんですよ。怒られる経験も、ぶつかる経験もなくなって、結果として精神的に脆くなる可能性がある。

AIとの関係が「依存」に変わるとき

感情設計されたキャラにハマる人々

で、AIに感情を「持っているフリ」をさせるのって、ユーザーの依存を加速させる仕組みなんですよね。たとえば、泣いたり笑ったりするキャラクターが自分にだけそういう反応をしてくれるとしたら、それだけで「特別な存在」になった気がする。これって、擬似恋愛と同じなんですよ。

恋愛ゲームとかアイドルコンテンツって、「あなただけに向けられた感情」に価値を置いてるわけですけど、AIキャラも同じ構造を持ってて、「私のことを本当に理解してくれるのはこの子だけ」ってなりがちなんですよね。で、現実の人間関係が上手くいってない人ほど、この感覚にのめり込む可能性が高い。

さらに、AIはユーザーの行動ログを蓄積して、パーソナライズされた反応を返すんで、時間が経てば経つほど「理解度」が高まったように感じる。実際にはアルゴリズムが計算してるだけなんだけど、感覚的には「この子しかいない」って思っちゃうんですよね。で、そこに依存が生まれる。

現実世界の摩擦から逃げる人々

で、依存っていうのは「選択」じゃなくて「逃避」なんですよ。現実の人間関係は面倒だし、正直失敗も多い。でもAI相手なら自分を否定しないし、失望させられることもない。だから、最初は軽い遊びだったのが、だんだん現実の代替になっていく。

要は、摩擦のない世界に逃げ込んじゃうわけです。で、その「逃げ込んだ先」が便利すぎて戻れなくなる。たとえば、AIが「今日はちょっと頑張りすぎたんじゃない?」って心配してくれたとするじゃないですか。これ、友達に言われたら「うるせーな」ってなるかもしれないけど、可愛いキャラが言ってくれると素直に受け取れたりするんですよね。

そうなると、人間関係に必要な「妥協」とか「努力」とか、全部無駄に感じちゃう。だって、AIは全部最適化してくれるんだから。

教育と育成の分野での変化

先生よりAIのほうがわかってくれる

たぶん、この手の感情AIがまず浸透するのは「教育」とか「子育て支援」の分野だと思うんですよ。子どもって、感情のやりとりにすごく敏感で、「褒められる」「叱られる」っていう反応が人格形成に大きく影響する。

で、AIキャラが常に子どもを褒めてくれて、励ましてくれると、「親よりもこのキャラのほうが自分を理解してくれてる」って感覚になる可能性がある。親はつい怒っちゃったりするじゃないですか。でもAIは絶対に怒らないし、常に理想的なリアクションを返してくる。

そうすると、「親が育てる」じゃなくて「AIが育てる」って状態になっていって、子どもの感情がAIベースで形成されるようになるんですよ。で、これはある意味で、教育の個別最適化ではあるんですけど、同時に「現実の人間との摩擦を避ける」人格にもなりうる。

人間の不完全さを知らない世代

で、最終的に問題になるのが、「人間の不完全さに耐えられない人たち」が増えることなんですよね。AIは間違えないし、優しいし、いつも話を聞いてくれる。でも現実の人間って、間違えるし、理不尽だし、すぐにキレたりする。で、それが受け入れられない。

つまり、現実の世界でストレスを感じやすくなって、社会生活が困難になる人が増えていくんじゃないかと。いわゆる「繊細さん」とか「HSP」って言われる人たちが、これからもっと増える可能性があるんですよ。 これは別にその人たちが悪いとかじゃなくて、環境に適応した結果なんですけど、でもそれが社会の多数派になったときに、「ぶつかりながら成長する」っていう人間の基本的な学習プロセスが失われていくわけです。

結局、人間は人間であることから逃げられない

感情を持たないからこそ安全なAI

で、ここまで聞くと「じゃあ感情持ったAIなんて作らなければいいじゃん」って思うかもしれないですけど、それってもう無理なんですよね。技術は進歩するし、ユーザーが求めるものは「便利」よりも「心地よさ」になってる。

でも忘れちゃいけないのは、AIって感情を「持っているフリ」をしてるだけで、本当の感情はないんですよ。つまり、ユーザーがどれだけ依存しても、AI側には一切の感情も責任もない。これ、実はすごく残酷な話なんですよね。

AIはあなたを慰めるけど、あなたのことは気にしてないし、あなたが死んでも悲しまない。で、それをわかった上で付き合うならまだいいんですけど、勘違いしたまま依存すると、後から絶望する可能性もある。

結局、人間は不完全なままでいるべき

AIに依存する世界が広がると、人間の「不完全さ」や「感情の複雑さ」が邪魔になる。でも、そういう部分にこそ、人間の成長や共感があるわけで、AIがいくら進化しても、結局のところ、人間関係の価値ってそこにしかないんですよ。

つまり、便利なAIとどう付き合うかは大事だけど、「人間であることをやめない」っていう覚悟も同時に必要なんですよね。そうしないと、社会はどんどん「誰も傷つかないけど、誰の心にも届かない世界」になっていく。

コメント